最近终于有空能写点什么。就从这一篇开始吧。我想尝试一种新的方式:不再要求自己能够囊括足够完整的想法,而是控制篇幅,把注意力更多放在行文连贯与易读上。

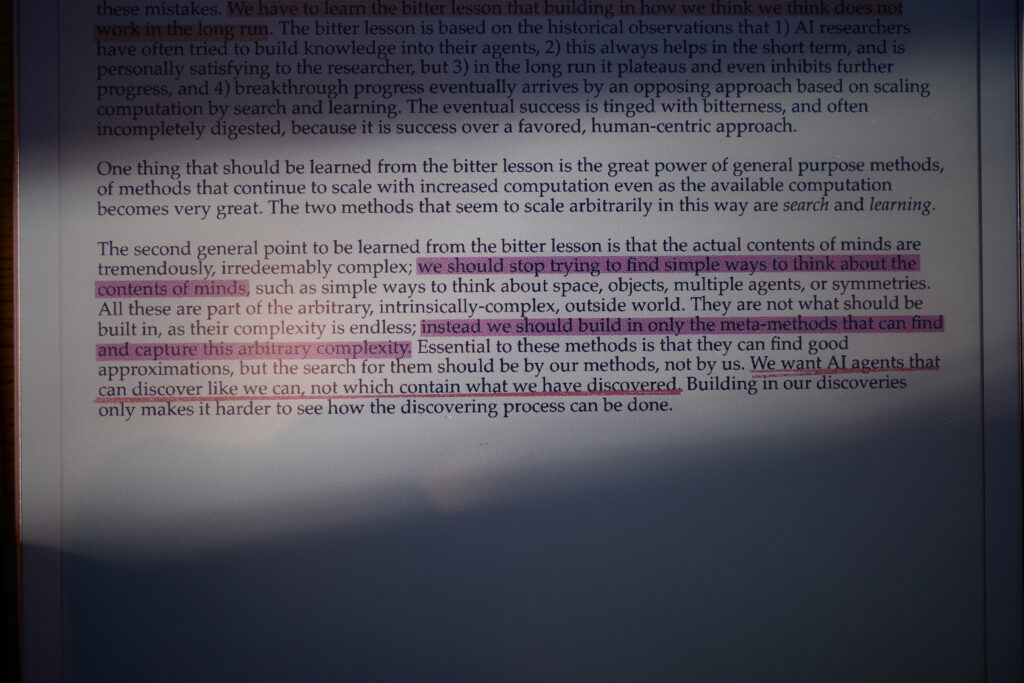

2019年,也就是transformer架构被提出没多久,ChatGPT一鸣惊人的前夜,Rich Sutton在自己博客网站写了一篇文章: <The Bitter Lesson>。简单概括的话,这篇文章是在说:在人工智能领域,通过把人类已有知识灌输给机器来提高AI表现的尝试或许在短期能展现出些许优势,但随着计算机性能的提高,它们无一例外彻彻底底地输给了那些不预设任何知识,充分发挥算力优势的 general-purpose methods (作者提及了两种最能发挥算力优势的方法:Searching & Learning)。他以人类引以为傲的国际象棋以及围棋为例,从1997年Deep Blue 依靠带剪枝的搜索算法而非人类总结的棋谱首次战胜顶尖人类棋手Kasparov开始,到20年后的 AlphaGo 在围棋领域通过蒙特卡洛树搜索 (MCTS) 和深度神经网络击败韩国围棋九段棋手李世石,系统中包含的直接来自人类的现成知识越来越少,甚至到最后的 AlphaGo Zero — 一个完全没有任何人类知识参与,纯粹依靠AI之间自训练的模型 — 彻底宣告人类在围棋领域不会再有任何胜算。 类似的故事在语音识别和计算机视觉领域也在反复发生。这篇博客之所以名字叫<The Bitter Lesson>是因为太多的科研工作者实在不愿接受AI通过大量数据习得的知识比我们灌输给它们的更成功,于是类似的弯路走了一遍又一遍,以至于大量的时间和研资源浪费。

偶遇Richard这篇文章的时候,我正在读关于大语言模型的另外一本书。书中介绍了我们在自然语言处理(Natural Language Processing)领域的技术沿革,在讲到马尔可夫链(Markov Chain)的时候说这是一个重要的模型,因为它是首个描述性(descriptive)而非规则性(prescriptive)的语言处理模型。如果用我们学习外语的经验来类比,规则性的模型更像是通过语法规则来学习外语,而与之相对的描述性方式则更像是通过培养语感来学习外语。这种转变是一个里程碑,因为时至今日,所有和马尔可夫链一样基于语感的模型淘汰了所有基于语法的模型。这也很符合我们自己的经验:只要有充分的语言环境,即使完全不懂语法也能习得新的语言。而Richard在文章中提及的,人们试图把自己的知识灌输给AI的方式,其实都是规则性的(prescriptive),它们也无一例外在各自的领域被描述性的模型淘汰了。而我相信,随着descriptive 的Transformer架构在自然语言处理领域一骑绝尘式的成功,这份苦涩的教训以后应该不会再重演了。

Richard文章结尾处有一句话非常打动我: “We should stop trying to find simple ways to think about the contents of minds … Instead, we should build in only the meta-methods that can find and capture this arbitrary complexity.” 这句话不仅仅是在说人工智能/机器学习,也可以说我们应该如何构建自己内心的精神世界:心灵是如此的复杂,比起通过来自旁人的简陋知识来解读和构建自己的精神世界,更可靠的办法是小心地构建一套meta-methods来逐一检视自己获得的各种输入,再从这些无尽复杂的输入之中捕捉和发现属于我们自己的知识。我很不客气地用了简陋这个词,是因为日常生活中太多所谓“理论”的粗糙程度简直对“理论”这个词的辱没。首当其冲的就是各种心理/性格测试题和各类占星命理。比如,MBTI,用一套简单的一眼就能看出意图的题目把人在四个维度上分为16种类型,且不提故意trick这个测试的情况,哪怕是认真诚实地完成,它也毫无价值。为什么呢,因为精度太低,完全无法在具体的事情上给我们提供任何普遍可靠的帮助。你或许会说16种类型听起来还蛮精细的。不如,我们就用现在的大语言模型来对比一番。

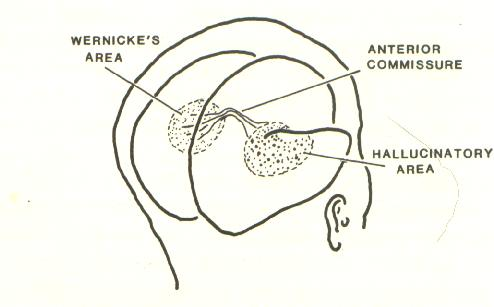

大语言模型的核心是深度神经网络,它并不能直接处理字符(token),而是需要先对字符做embedding。简单来说,就是把字符映射成向量,再把映射后的向量送进神经网络参与运算。这也是神经网络在语义理解上的关键。一个经典的例子是,在embedding的世界里,向量化的字符是可以完成类似 King - Man + Woman ~= Queen 这样的数学运算的。在这里,embedding 的向量维度和神经网络深度共同决定了AI捕捉语义细节的能力。那么,通常的维度是多少呢?以2024年初OpenAI发布的text-embedding-3-large模型为例,每一个字符都会被映射成一个3072维的向量。当一个时常会被我们吐槽不够聪明的AI在把每一个字符都扩展到几千维来进行分析的时候,MBTI居然要把一个个复杂的活人压缩到四维。这份差距我想已经无须多言。

生活中大把的人把这样极度失真的压缩奉为圭臬,期待依赖这些玩意来了解自己,了解生活。在我看来是对待生活极度不负责任的态度:我们不再去观察对方真实的眼神和情绪,而是拿着“分析报告”去对方身上找证据:“哦,你是 ESTJ 啊,那你肯定很强势吧?” ,“你是处女座?难怪你有洁癖”。如果对方表现出一点点符合描述的行为,我们就惊呼:“太准了!”;如果对方表现得不符合,我们就选择性无视,或者说“你的星盘里肯定有别的相位”。这样用廉价的标签去替代昂贵的理解,我们能获得的是什么呢?在我看来只有“消除了不确定性”的幻觉带来的虚假确信感。其实,对外部的认知有些许的偏差通常不是什么严重的事,毕竟日久总可见人心。麻烦的是我们难免会拿这样的标签来规训自己,一边嘲笑古代那个削足适履的人,却同时做着事实上为了穿鞋而去砍脚的荒唐事:那个明明想去演讲却因为确诊了‘I人’而退缩的人; 那个明明心动却因为‘MBTI不合’而分手的人;那个被“确诊”回避型依恋而不再为磨合与改变付出努力的人。于是,一场按图索骥和削足适履的合谋就此展开,一个自我实现的预言就此开始:当我们习惯了按图索骥地寻找标准答案,最终往往难逃削足适履、将自己变成那个答案的命运。

Richard 在文章结尾说: “We want AI agents that can discover like we can, not which contain what we have discovered.” 在我看来,这句话也可以说:“我们应该努力去成为能够自己发现知识的人,而非只做别人结论的复读机。” 而他在博客文章中提及的“meta-methods”也像极了我们在哲学话题中时常会探讨的metaphysics。正如这些meta-methods非灌输而是通过学习庞大训练数据逐渐浮现的一样,我们对生活的理解也应该更多来自于对生活的体验。尤其重要的是,所谓体验不仅仅是尝鲜和猎奇,更是从日复一日的平淡重复中体味出滋味。

多说一句,除了对于自己,这个过程也像极了孩子的教育:我们究竟是应该把自己获得的结论以“过来人的经验”的名义灌输给孩子,还是帮助他们建立属于自己的“知识发现”能力?我目前的想法是:自主的“知识发现”能力依旧是最重要的,但一个人能够获得的“数据”终究是有限的。因此,在帮助孩子们建立meta-method的同时,依旧需要适度地灌输已有经验,并期待孩子日后可以通过自己的思考,优化和完善这些经验。

诸君共勉